驳“目录的长度(深度)影响SEO优化效果”论

在全通公司工作也有两年了,在这两年里,有一个SEO优化问题是经常被客户提及:网站后台的目录太深了,足足有四个文件夹,很不利于SEO优化的。面对这个问题时,小莫通常会选择反问他们一句:为什么觉得这会影响SEO优化呢?他们对此的回答多半为:目录深了,url就会变得很长,用户体验也就不好了,甚至会影响到权限和蜘蛛抓取。对此,小莫特意去搜索了相关的文章,的确也有这种说法的文章。但是,由于小莫从事网站建设行业多年,也曾做过搜索引擎相关的系统开发工作,对于蜘蛛原理也算是有一点了解。所以,今天就从技术层面来为大家分析一下,为什么小莫会觉得这些论调是错误的。

在反驳相关问题之前,我们还是先来了解一下网络蜘蛛和网站权重的基本知识先吧。

一、网络蜘蛛

网络蜘蛛,别名网络爬虫,是一种按照一定的规则,自动地抓取万维网信息的程序或者脚本。传统的爬虫会从宇哥或若干初始网页的url开始,获得初始网页的url,在抓取网页的时候,会不断的从前一个页面上抽取新的url放到队列之中,直到满足了系统的一定条件后,再对抓取到的页面进行不同的分析和处理,以提高智能化的搜索结果排名。如果把整个互联网当成一个网站,那么网络蜘蛛就可以用这个原理把互联网上所有的网页都抓取下来。

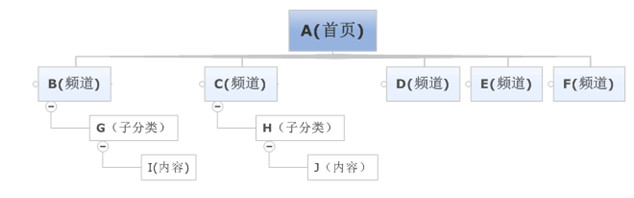

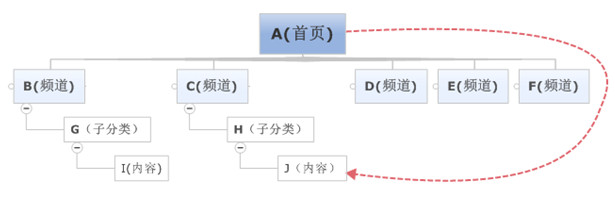

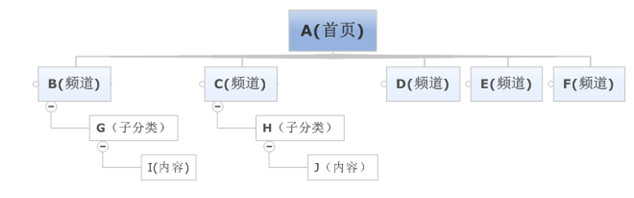

由于蜘蛛无法抓取互联网上的所有网页,所以会对一些不是那么重要的网站设置访问层数。如,在图1中,A为起始网页,属于0层,B、C、D、E、F属于第1层,G、H属于第2层,I、J属于第3层。如果网络蜘蛛设置的访问层数为2的话,网页I、J是不会被访问到的。这也让有些网站上一部分网页能够在搜索引擎上搜索到,另外一部分不能被搜索到。但按如图2中,假如J的层级在A层级中出现,则J被视为和A一样的同一级,也会被抓取。所以,对于网站设计者来说,扁平化的网站结构设计有助于搜索引擎抓取其更多的网页。

图一

图二

网络蜘蛛进入一个网站时,首先会去访问一个特殊的文本文件,那就是Robots.txt。一般来说,这个文件会放在网站服务器的根目录下,网站的管理员可以通过Robots.txt来定义那些目录是网络蜘蛛不能爬行的,或者是哪些目录是哪些搜索引擎蜘蛛无法爬行的。例如有些网站的可执行文件目录和临时文件目录不希望被搜索引擎搜索到,那么网站管理员就可以把这些目录定义为拒绝访问目录。Robots.txt语法很简单,例如如果对目录没有任何限制,可以用以下两行来描述: User-agent: * Disallow:

当然,Robots.txt也只是一个协议而已,如果网络蜘蛛的设计者不想遵守这个协议的话,网站管理员是无法阻止网络蜘蛛对某些页面的访问的。但是,一般来说,网络蜘蛛都会遵守这个协议的。其实,我们除了通过Robots.txt来拒接网络蜘蛛的爬行之外,我们还可以通过其他方法来拒接网络蜘蛛的爬行的。

网络蜘蛛在下载网页的时候,会去识别网页的HTML代码,在其代码的部分,会有META标识。通过这些标识,可以告诉网络蜘蛛本网页是否需要被抓取,还可以告诉网络蜘蛛本网页中的链接是否需要被继续跟踪。例如: 表示本网页不需要被抓取,但是网页内的链接需要被跟踪。

一般的网站都希望搜索引擎能更全面的抓取自己网站的网页,因为这样可以让更多的访问者能通过搜索引擎找到此网站。为了让本网站的网页更全面被抓取到,网站管理员可以建立一个网站地图,即Site Map。许多网络蜘蛛会把sitemap.htm文件作为一个网站网页爬取的入口,网站管理员可以把网站内部所有网页的链接放在这个文件里面,那么网络蜘蛛可以很方便的把整个网站抓取下来,避免遗漏某些网页,也会减小对网站服务器的负担。

二、网站权重

在了解了网络蜘蛛的基本原理之外,接下来,我们就一起去了解一下,网站权重的基本知识吧。

网站权重,一般是指:搜索引擎对网站进行评估评价后,给网站赋予的一定的权威值。一个网站的权重越高,那么这个网站在搜索引擎中所占的分量也就越大,关键词排名也就越好。虽然说,基本每一个SEOER都会讨论和研究网站权重。但是,在某些搜索引擎中,这个标准是不存在的。概括的说:就是网站与网站在搜索引擎眼中的分级制“待遇”的不同表现。误区:例如人们经常讨论的百度权重其实并不是百度官方给出的概念,而是一些第三方站长网站推出的针对网站关键词排名预计给网站带来流量,划分等级0-10第三方网站欢迎度评估数据。影响网站权重的因素较多,主要有以下几种:

网站架构

网站结构不尽需要迎合搜索引擎的喜好,更要符合用户体验的要求。而优质的网站架构一般为扁平式,既:主页>栏目页>内容页,同时站点还应包含TAG标签,留言评论、文章搜索等。

域名类型

一般来说,gov和edu类型的域名的权重会比较高一点。因为,用这一类域名的站点基本为政府高校的网站,很少是草根个人的小站。其实,com、net、org的域名权重相对较高,一些有国家和地区特点的域名后缀建议不要选。从用户习惯来看,com已成为首选。最后域名的注册年龄越久,搜索引擎给予的信任越高。

导入链接

虽然外链的时代已经过去了。但是,外链对于网站来说,还是很重要的。只是在今时今日,我们不仅需要做好外链的数量,更需要做好外链的质量。只有优质的外链,才能帮助到网站。如果一昧的提高外链的数量,则是很容易受到搜索引擎的惩罚的。

网站内容

“外链为皇,内容为王”这句话充分的表达出了,内容对于网站权重的重要性。如果能长时间为网站创造出优质的原创内容的话,网站权重自然会蹭蹭往上加的。因为,原创内容就是为搜索引擎注入新鲜的血液。如果,实在原创不出什么内容的时候,那就伪原创一下。。切忌原封不动的复制粘贴,尤其是机器采集后进行所谓的自动伪原创,更有甚者前后两段抄堆叠关键词或者所谓的伪原创,其实段落语句不通,用户体验差,网站跳出率高,同样也不会有好的权重。

收录数量

坚持更新站点,合理布置链接诱饵,增加站点页面的收录数量。虽说收录数量与权重之间不是绝对关系,但你见过同类型同行业的网站收录数量仅有几十的权重高于几万的情况吗?

关键词排名

尤其是核心关键词的排名。首先要明白搜索引擎为什么会给你的关键词一个较高的排名,因为权重高了。其次,认真做好相关关键词和长尾关键词的排名,这有利于提升网站的整体权重。

更新频率

坚持有规律的更新网站,除了会获得及时的网页快照外,还能增加搜索引擎的信任度,一个更新频繁的网站比那些僵尸网站的权重肯定会高很多。同时,应注意更新时间和更新数量,避免之前积累的权重慢慢流失了。

内容页

内页是否和首页以及网站主题有较为紧密的联系,内页之间的衔接、关键字的布局,以及内页是否具有专业性,权威度如何。

网站的诚信度

Google除PR值以外,还有一个诚信指数。即通过对一些高质量网站的分析,给出一个“诚信”网站应该有的一些指标,并用这些指标来分析一个网站的诚信度。

网站服务器

服务器稳定是关键,如果说搜索引擎抓取页面时网站空间无法访问,特别是新站,网站服务器不稳定可能导致搜索引擎不收录网站。其次是网站页面的打开速度,这些服务器因素对权重都有影响。

最后声明下,权重跟排名不能划为等号;就像PR≠排名,当然这只是SEO细节中的一个重要组成部分。权重的高低是影响关键词排名其中的一项重要因素而已。

三、路径原理及影响

说完了网络蜘蛛和网站权重的基本原理之后,下面我们就用这些原理来阐述一下,域名路径的长短是否会影响到SEO优化的效果呢?

首先,我们先去了解一下静态路径的规则:

静态路径的规则为:域名/静态总目录/语言目录/主分类/子分类/内容名.html,其实静态总目录是可以去掉或者修改的。如果为单语言的情况下面,语言目录也是可以去掉的,但如果为多语言,则此目录必须保留,以避免相同语言相同目录及内容的覆盖。

在上面介绍中,我们说过网络蜘蛛抓取,是根据页面访问层级来进行抓取的,而不是目录层级,如下图所示:

假如现在内容J中有URL为:http://www.szqt.net/news/xingyeba/10519.html,如果此内容的链接出现在J和出现在A层,那么可以分别理解为0层和3层,这种意义是不一样。如果出现在A层中,那么网络蜘蛛在第一次抓取中就比较容易寻获取此URL,并进行抓取保存,而如果出现在J层中,那么当网络蜘蛛只设定了二层后,就抓取不到了。这种层级关系的理解,不是域名文件夹的层级关系,而是浏览深度指向的层级。

所以说,网站后台生成的静态URL文件夹的多与少,其实对SEO优化效果来说,基本是没有影响的。但是,如果你的网站是英文网站的会啊,那么请注意了文件夹的生成文件名,是有一定的影响的。比如产品文件夹的名称设定成products和设定成cb,那是有很大的关系的,所以切记一条:文件夹尽量取英文名或者英文代表关键字。

那有人又会说了:既然您网络蜘蛛没有影响,那权重呢?总会有一定的影响吧?先前说过了,网页权重影响主要是内容质量、关键字、域名、点击数量、收录数量、服务器速度等因素,URL的长短实际很少,如果不信,您要中以搜索一下百度或者谷歌,他们收录中,同样有非常长的URL网页。

谈了这么多原理性之后,不知您还是否跟其它SEOER一样,同样认为URL长度影响质量呢?如果您还坚持您的观点,可以多了解一下搜索技术方面的文章,而不是SEO营销方面的文章,SEOER更不该误人子弟,正确理解SEO的重要性,还是对您网站内容的质量、内链着手吧!